Data-Drive Agriculture; Big Data, Cloud & AI aplicados

José Carranceja

Director Operaciones América

En toda la cadena de valor del mercado agroalimentario hay realmente infinidad de soluciones de aplicación de tecnologías de analítica avanzada, empezando por soluciones cercanas al cliente final bajo el paraguas de los CRM y el Social Marketing, pasando por soluciones de automatización de procesos productivos bajo los ERP y la robotización de las operaciones, y por descontado soluciones de toda la cadena de logística en el ámbito del SCM, desde la optimización de rutas a la de activos en almacén. Pero son quizás menos conocidas y más específicas de agricultura, aquellas soluciones cercanas a los procesos iniciales en los cultivos y la producción de la materia prima alimentaria.

Probablemente este mercado se ha mantenido reticente a la implantación de grandes proyectos de transformación digital y por ello marginal para los grandes players, debido a la gran dispersión de los productores y su poca coordinación por iniciativas públicas. Pero aún con eso, marcas de la relevancia de Syngenta, DJI, Slantrange o John Deere representan en este momento ejemplos indudables de aplicación de las últimas tecnologías de analítica y datos en el sector.

En las fases productivas la combinación de sensores, drones, reconocimiento de imagen, termografía y espectrografía, vehículos autónomos y biotecnología han conseguido además de multiplicar las capacidades productivas, una drástica reducción de mano de obra, insumos químicos y uso de agua.

Actualmente además de los avances en sistemas de predicción meteorológica, los sistemas GPS o la fotografía satelital, los drones son una de las áreas de mayor desarrollo. Estas plataformas proporcionan información detallada sobre situación hidrológica, maduración de la cosecha o situación fitosanitaria. Las cámaras que montan actualmente plataformas Drone como DJI, permiten desde levantar geometrías tridimensionales del terreno, a identificar con precisión de centímetros donde aplicar agua o productos fitosanitarios y hasta el momento más adecuado para la cosecha de cada metro cuadrado. Todo ello mediante servicios disponibles en plataformas en la nube, utilizando algoritmos disponibles capaces de identificar número y tamaños de cosecha, o plagas específicas y su localización.

Actualmente además de los avances en sistemas de predicción meteorológica, los sistemas GPS o la fotografía satelital, los drones son una de las áreas de mayor desarrollo. Estas plataformas proporcionan información detallada sobre situación hidrológica, maduración de la cosecha o situación fitosanitaria. Las cámaras que montan actualmente plataformas Drone como DJI, permiten desde levantar geometrías tridimensionales del terreno, a identificar con precisión de centímetros donde aplicar agua o productos fitosanitarios y hasta el momento más adecuado para la cosecha de cada metro cuadrado. Todo ello mediante servicios disponibles en plataformas en la nube, utilizando algoritmos disponibles capaces de identificar número y tamaños de cosecha, o plagas específicas y su localización.

Tecnologías donde el procesamiento masivo de imágenes (gráficas, térmicas o espectrográficas) y la identificación de patrones son un elemento fundamental.

No hay que olvidar la gran evolución que los productos de origen químico o biológico están suponiendo. Syngenta a la cabeza de la producción de fertilizantes, semillas y productos fitosanitarios, promueve anualmente su Crop Challenge in Analytics en el que premia proyectos de analítica en todo el mundo para el desarrollo de sistemas eficientes y sostenibles.

Una característica relevante de este sector son los marketplaces, además de las soluciones cloud integradas que procesan las imágenes, proporcionan los resultados y generan las decisiones que conllevan, estos marketplaces provén también los modelos y algoritmos parametrizables para aplicarlos a tus datos. Slantrange a nivel internacional o Hemav en España son referentes de estas plataformas cloud integradas. Y plataformas como Keras o Caffe permiten no quebrarse la cabeza desarrollando algoritmos. Sencillamente hay que buscar los más adecuados, parametrizarlos para tu set de datos y ponerlos a competir para buscar el más eficiente. En Open AI están surgiendo nuevos modelos cada 18 meses.

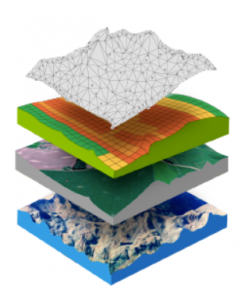

Otro elemento fundamental son las plataformas de datos abiertos, desde meteorológicos, satelitales o geológicos a históricos en determinadas geografías. El cruce de estos con los datos propios, permiten desde predecir mejor fenómenos meteorológicos y su impacto en la maduración de la cosecha a predecir el futuro volumen de la misma y su valor en el mercado.

Otro elemento fundamental son las plataformas de datos abiertos, desde meteorológicos, satelitales o geológicos a históricos en determinadas geografías. El cruce de estos con los datos propios, permiten desde predecir mejor fenómenos meteorológicos y su impacto en la maduración de la cosecha a predecir el futuro volumen de la misma y su valor en el mercado.

Finalmente, un elemento diferencial son los vehículos autónomos de empresas como John Deere que fabrica tractores que utilizan los mismos modelos de inteligencia artificial usados en coches autónomos tan sofisticados como el Waymo de Alphabet. Modelos de reconocimiento de imagen permiten colocar y medir las actuaciones de forma que llegan a reducirse en la aplicación de herbicidas o fertilizantes entre un 70 a un 90%. Hay que tener en cuenta que en condiciones normales aproximadamente un 50% de los fertilizantes se pierden en el ambiente.

Finalmente, un elemento diferencial son los vehículos autónomos de empresas como John Deere que fabrica tractores que utilizan los mismos modelos de inteligencia artificial usados en coches autónomos tan sofisticados como el Waymo de Alphabet. Modelos de reconocimiento de imagen permiten colocar y medir las actuaciones de forma que llegan a reducirse en la aplicación de herbicidas o fertilizantes entre un 70 a un 90%. Hay que tener en cuenta que en condiciones normales aproximadamente un 50% de los fertilizantes se pierden en el ambiente.

En este contexto la revista 360 Market Updates en su informe de 2020, identifica para el mercado al que nomina como “Global Connected Agriculture”, una expectativa de crecimiento CAGR de 17.08% durante el periodo entre 2020 y 2024. Y los grandes players no son ajenos a esta perspectiva.

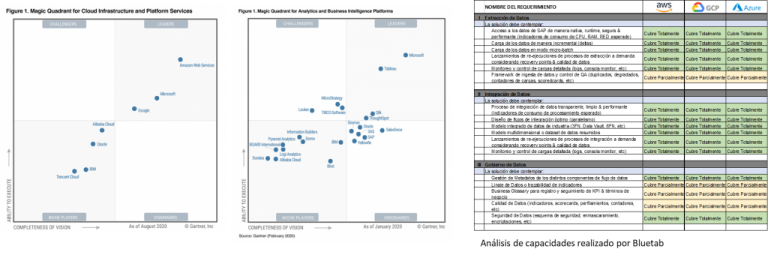

Intentando discriminar los principales actores en servicios cloud, según Gartner, en este momento son Google GCP, Amazon AWS y Microsoft Azure los lideres diferenciados tanto en infraestructura como en plataforma de analítica o BI. Pero es deficit identificar la más adecuada a un requerimiento genérico, incluso bajando a un nivel de detalle preliminar.

En nuestro análisis de las tres plataformas en el que hemos evaluado capacidades de extracción, integración y gobierno fundamentales, concluimos que las tres cuentan con servicios capaces de dar cobertura equivalente. Evidentemente las politicas de precio de todas se adaptan a los requerimientos de cada situación en los mismos términos de competitividad.

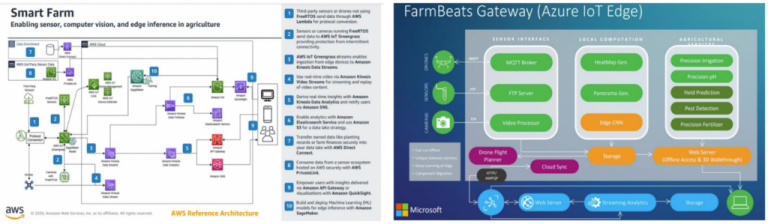

No obstante, bajando al terreno de las soluciones para el sector agroalimentario son AWS y Azure las que han desarrollado modelos de aproximación específicos. Ambos han desarrollado plataformas de integración para soluciones IoT, han integrando servicios para volcado de información de todo tipo de sensores, dispositivos o máquinas, y habilitando servicios para hacerlo tanto en streaming como en batch.

Tanto AWS como Azure cuentan con partners que apoyan los procesos de extracción de dichas plataformas IoT y aseguran las comunicaciones y la captación de los datos. Pero quizás Microsoft ha ido un paso más allá invirtiendo en partners con soluciones específicas end to end en el segment en el que son diferenciales en el sector. Un ejemplo de ello es Slantrange, que cubre el proceso completo que realizan los drones desde la generación de los planes de vuelo al procesamiento de las imagenes tanto termicas como termográficas y su explotación para la toma de decisions por los agricultores. Y en esa misma línea, Microsoft ha llegado a acuerdos con plataformas de drones líderes del mercado como DJI o AirMap y ha desarrollado una plataforma de simulación de vuelo Drone Flight Simulator 3D. Toda esta estrategia focalizada en el eslabón de origen de la cadena del negocio, le proporciona un paso adicional para la preparación de los datos previa al procesamiento en sus plataformas de inteligencia artificial.

El servicio Azure FarmBeats, permite la creación de un espacio especializado para el agricultor donde están integradas las capacidades de procesamiento de imagen de drones o satelital, así como algoritmos de análisis para la toma de decisions sobre cosechas.

Desde Bluetab vemos como la evolución de servicios de las tres plataformas están en un momento de extraordinaria evolución y las tres han entrado en una feroz carrera por asegurar que están a la altura de los servicios de sus mas cercanos competidores. Hoy en día cualquiera de las llamadas “killer application” como Kubernetes o kafka están disponibles en las tres y permiten unos niveles de integración de servicios, hasta ahora inpensables. Por ello, en el análisis de la decision de la Plataforma, hay que incluir también otras variables de decisión importantes como son el nivel de implantación de la Plataforma en nuestro mercado local y la disponibilidad de recursos formados, la integración con nuestras plataformas actuales on premise o las políticas comerciales de cada una de ellas.

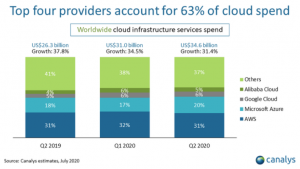

Podemos decir en términos generales, que actualmente la plataforma AWS lleva la delantera a sus competidores en lo que tiene que ver con posición de mercado, si bien ha tenido una pequeña reducción de su posición en el ultimo año. Y esto hace que en mercados como España o México nuestra percepción es que el número de recursos disponibles es tambien mayor.

Podemos decir en términos generales, que actualmente la plataforma AWS lleva la delantera a sus competidores en lo que tiene que ver con posición de mercado, si bien ha tenido una pequeña reducción de su posición en el ultimo año. Y esto hace que en mercados como España o México nuestra percepción es que el número de recursos disponibles es tambien mayor.

Sin embargo, es claro que el nivel de preexistencia de soluciones Microsoft en el mercado corporativo y las facilidades de integración de toda su plataforma office con soluciones específicas como Power BI, hacen que la afinidad de uso para los usuarios posicione a Azure como la solución alternativa más demandada. Actualmente Power BI es una de las tres plataformas de explotación lideres conjuntamente con Tableau y Qlik.

Por otro lado, Google con GCP focaliza su estrategia en sus soluciones específicas de inteligencia artificial y machine learning como son sus soluciones de lenguaje natural o reconocimiento de imagen y sus plataformas tensorflow. Todo ello apoyado por la integración con sus plataformas de servicios bien conocidas como Maps o Adds. Y todo ello hace que su posición como tercer player esté afianzándose.

Finalmente hay que tener en cuenta dos puntos adicionales, el primero es que cada vez más el concepto multicloud es una realidad y herramientas como VM Ware permiten soluciones de gestion integradas para la coexistencia de diferentes soluciones con diferentes clouds. Por ello y este es el segundo punto, hay que evaluar los requerimientos específicos de cada servicio para valorar si alguna de ellas tiene un nivel de desarrollo superior. Así por ejemplo, en lo que tiene que ver con plataformas de gaming, Microsoft con Xbox parecería ser el lider, pero en este momento Lumberyard el motor de videjuegos y Twitch, ambos de AWS o Google Stream están entrando con fuerza. Y como en esto, en todos los segmentos, los tres competidores se reposicionan en pocos meses, por lo que las ventanas de diferenciación son a veces marginales.

Un mercado apasionante donde cada vez más las tres plataformas AWS, GCP y Azure, dificultan el acceso a otras como Alibaba, IBM y otros competidores, y profundizan en su posición generando oligopolios reales… pero este complejo asunto lo abordaremos en otra occasion.

¿Quieres saber más de lo que ofrecemos y ver otros casos de éxito?

Actualmente COO de Bluetab para América, y ha desarrollado su carrera profesional en diferentes puestos de gestión internacional en áreas de ventas y consultoría en empresas como IBM, BT o Bankinter. Además, ha liderado iniciativas de emprendimiento como JC Consulting Ass. de consultoría tecnológica o Gisdron un start up de servicios drone. Es Arquitecto especialista en cálculo de estructuras y se ha formado en escuelas de posgrado como IESE, INSEAD o el TEC de Monterrey.